Материалы по тегу: pci express 5.0

|

19.05.2024 [18:07], Игорь Осколков

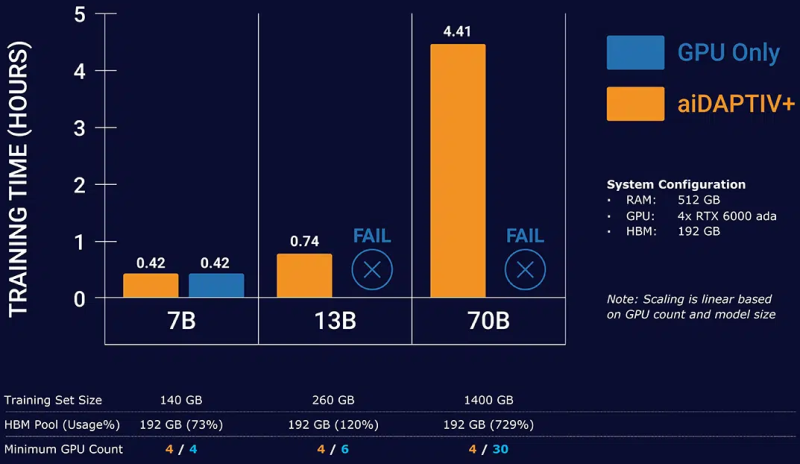

Phison представила новый бренд серверных SSD PASCARI и накопители X200 с PCIe 5.0Phison представила собственный бренд SSD корпоративного класса PASCARI, который включает сразу несколько различных серий: X, AI, D, S и B. Новинки представлены в форм-факторах E1.S, E3.S, U.3/U.2, M.2 2280/22110 и SFF 2,5″ и наделены интерфейсами SATA-3 и PCIe 4.0/5.0. Наиболее интересна серия AI (или aiDAPTIVCache), которая фактически является частью программно-аппаратного комплекса aiDAPTIV+. Пока упоминается только один M.2 SSD — AI100E. Это сверхбыстрые и сверхнадёжные 2-Тбайт NVMe-накопители на базе SLC NAND (вероятно, всё же eSLC) с DWPD, равным 100 на протяжении трёх или пяти лет (в материалах указаны разные сроки). Аналогичные накопители, хотя и в более крупном форм-факторе, предлагают Micron и Solidigm, а Kioxia в прошлом году анонсировала накопители на базе XL-Flash второго поколения с MLC NAND. Во всех случаях, по сути, речь идёт об SCM (Storage Class Memory). Наиболее ярким представителем данной категории была почившая серия продуктов Intel Optane. Phison переняла общую идею перестройки иерархии памяти, где SCM является ещё одним слоем между DRAM и массивом SSD, приложив её к задачам обучения ИИ. AI100E являются кеширующими накопителями, расширяющими доступную память. Программная прослойка aiDAPTIVLink общается с ускорителями NVIDIA и SSD с одной стороны и с PyTorch (также есть упоминание TensorFlow) — с другой. aiDAPTIVLink позволяет автоматически и прозрачно переносить на SSD неиспользуемые в текущий момент части обучаемой LLM и по необходимости отправлять их сначала в системную RAM, а потом и в память ускорителя, что и позволяет обходиться меньшим числом ускорителей при тренировке действительно больших моделей. Естественно, никакого чуда здесь не происходит, поскольку время обучения от этого нисколько не сокращается, но с другой стороны, обучение становится в принципе возможным на системах с малым количеством ускорителей или просто с относительно слабыми GPU и относительно небольшим же объёмом системной RAM. Среди уже поддерживаемых моделей упомянуты некоторые LLM семейств Llama, Mistral, ResNet и т.д. Для них, как заявляется, не нужны никакие модификации для работы с aiDAPTIV+. Также упомянута возможность горизонтального масштабирования при использовании данной технологии. Точные характеристики AI100E компания не приводит, но это и не так существенно, поскольку напрямую продавать эти накопители она не собирается. Вместо этого они будут предлагаться в составе готовых и полностью укомплектованных рабочих станций или серверов. Семейство PASCARI X включает сразу четыре серии накопителей. Так, X200E (DWPD 3) и X200P (DWPD 1) — это двухпортовые накопители на базе TLC NAND с интерфейсом PCIe 5.0 x4, представленные в форм-факторах U.2 и E3.S. Пиковые скорости последовательного чтения и записи составляют 14,8 Гбайт/с и 8,35 Гбайт/с соответственно. На случайных операциях с 4K-блоками производительность чтения достигает 3 млн IOPS, а записи — 900 тыс. IOPS у X200E и 500 тыс. IOPS у X200P. Здесь и далее даны только крайние показатели в рамках серии, а не отдельного накопителя. Ёмкость X200E составляет 1,6–12,8 Тбайт, но также готовится 25,6-Тбайт U.2-версия. У X200P диапазон ёмкостей простирается от 1,92 Тбайт до 15,36 Тбайт, но опять-таки будет 30,72-Тбайт вариант в U.2-исполнении. Отмечается поддержка MF-QoS (QoS для различных нагрузок), поддержка 64 пространств имён, MTBF на уровне 2,5 млн часов, сквозная защита целостности передаваемых данных, улучшенная защита от потери питания и т.д. У X100E (DWPD 3) и X200P (DWPD 1) среди возможностей дополнительно упомянуты поддержка TCG Opal 2.0, NVMe-MI, шифрования AES-256, безопасной очистки и т.д. От X200 эти накопители отличаются в первую очередь интерфейсом PCIe 4.0 x4 (возможны два порта x2). Выпускаются они только в форм-факторе U.3/U.2. X100E предлагают ёмкость от 1,6 Тбайт до 25,6 Тбайт, а X100P — от 1,92 Тбайт до 30,72 Тбайт. Пиковые скорости последовательного чтения и записи в обоих случаях достигают 7 Гбайт/с. Произвольное чтение 4K-блоками — до 1,7 млн IOPS, а вот запись у X100E упирается в 480 тыс. IOPS, тогда как у X100P и вовсе не превышает 190 тыс. IOPS. В семейство PASCARI D входит всего одна серия компактных накопителей D100P на базе TLC NAND с интерфейсом PCIe 4.0 x4 (один порт, NVMe 1.4), представленная в форм-факторах M.2 2280 (от 480 Гбайт до 1,92 Тбайт), M.2 22110 (от 480 Гбайт до 3,84 Тбайт) и E1.S (тоже от 480 Гбайт до 1,92 Тбайт). Производительность M.2-вариантов составляет до 6 Гбайт/с и 2 Гбайт/с на последовательных операциях чтения и записи, а на случайных — до 800 тыс. IOPS и 60 тыс. IOPS соответственно. E1.S-версия чуть быстрее в чтении — до 6,8 Гбайт/с. Надёжность — 1 DWPD. Среди особенностей вендор выделяет сквозную защиту целостности данных, LPDC-движок четвёртого поколения, поддержку NVMe-MI и т.п. PASCARI B включает серию загрузочных накопителей B100P: M.2 2280 (будет и 22110), TLC NAND, PCIe 4.0 x4, 1 DWPD и те же функции, что у D100P. Доступны только накопители ёмкостью 480 Гбайт и 960 Гбайт. Скоростные характеристики относительно скромны. Последовательные чтение и запись не превышают 5 Гбайт/с и 700 Мбайт/с, а произвольные — 450 тыс. IOPS и 30 тыс. IOPS. Также к PASCARI B принадлежит серия BA50P: SATA-накопители в форм-факторах M.2 2280 и SFF 2,5″ на базе TLC NAND с DWPD 1 и ёмкостью 240/480/960 Гбайт. Скорости чтения/записи не превышают 530/500 Мбайт/с при последовательном доступе, и 90/20 тыс. IOPS при случайном доступе 4K-блоками. Наконец, семейство PASCARI S представлено тремя сериями SFF-накопителей (2,5″) с TLC-памятью и интерфейсом SATA-3, отличающихся в первую очередь опять-таки показателем надёжности: SA50E (3 DWPD), SA50P (1 DWPD) и SA50E (>0,4 DWPD). SA50E имеют ёмкость от 480 Гбайт до 3,84 Тбайт, SA50P — от 480 Гбайт до 7,68 Тбайт, а SA50E — от 1,92 Тбайт до 15,36 Тбайт. Отличаются и максимальные скорости произвольного чтения/записи 4K-блоками: 98/60 тыс., 98/40 тыс. и 97/20 тыс. IOPS соответственно. А вот последовательные чтение и запись естественным образом ограничены самим интерфейсом, т.е. не превышают 530 Мбайт/с и 500 Мбайт/с соответственно. В описании упомянуты сквозная защита целостности данных, LPDC-движок и улучшенная защита от потери питания. Для вообще всех накопителей заявленный диапазон рабочих температур простирается от 0 до 70 °C. А вот срок гарантии не указан, так что показатели DWPD теряют смысл. Кроме того, Phison практически для каждой серии говорит о возможности кастомизации. Например, для X100 предлагаются услуги IMAGIN+.

13.05.2024 [10:30], Сергей Карасёв

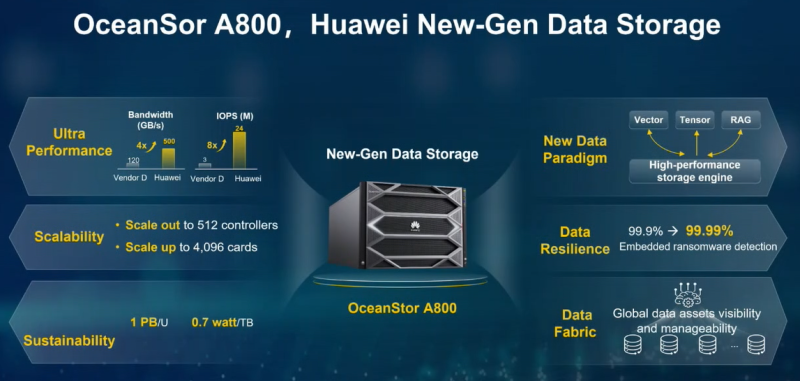

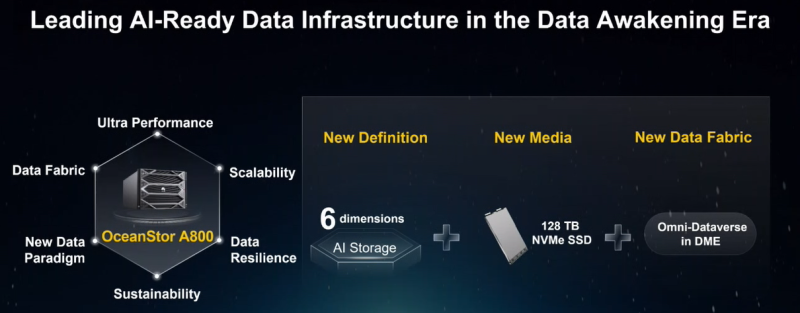

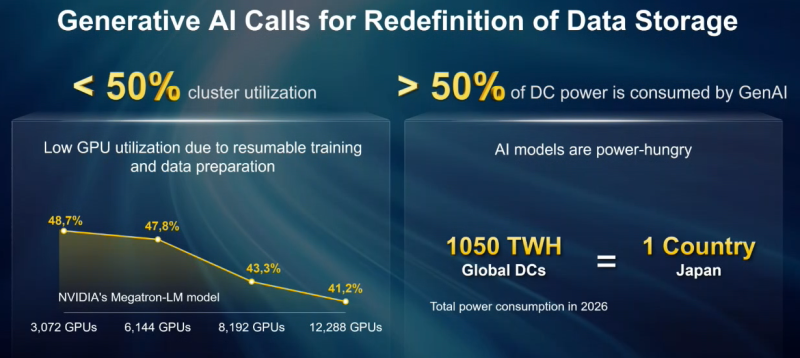

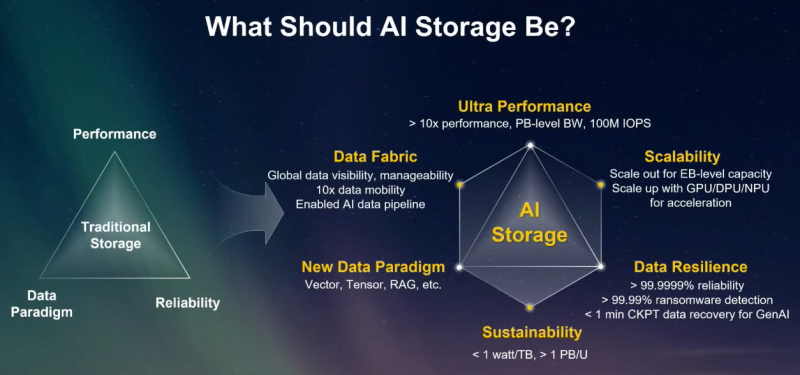

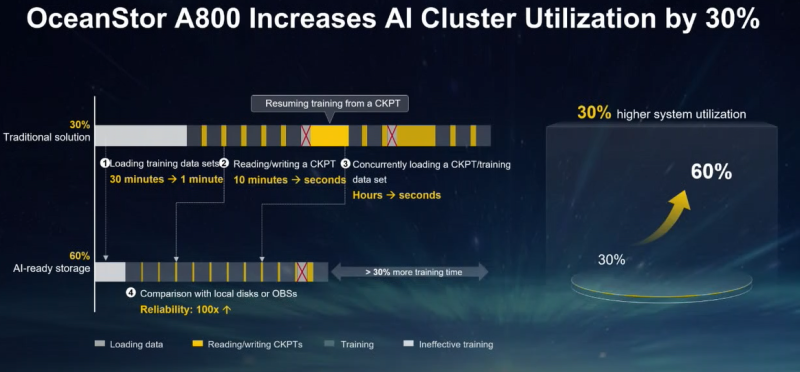

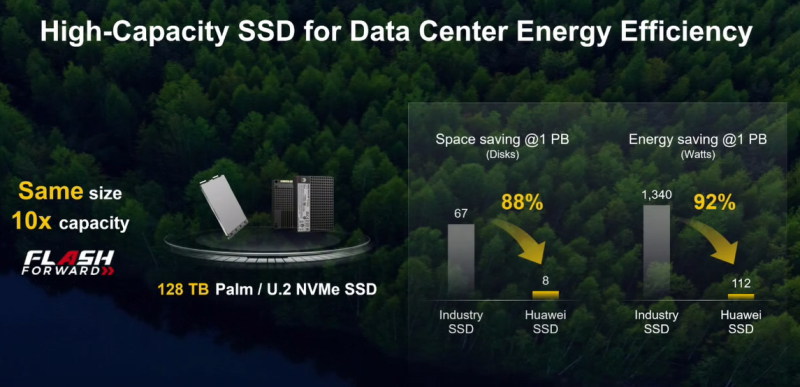

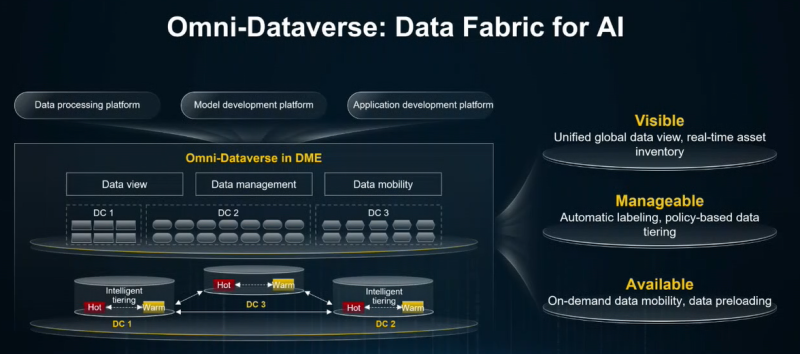

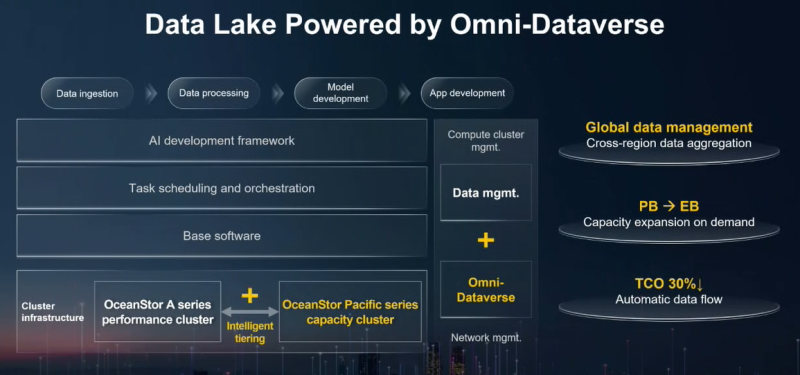

Экзабайты для ИИ: Huawei представила All-Flash СХД OceanStor A800Компания Huawei, по сообщению Datacenter Dynamics, представила СХД нового поколения OceanStor A800, специально разработанную для задач ИИ. Новинка позволяет формировать массивы экзабайтного уровня. Питер Чжоу (Peter Zhou), президент подразделения систем хранения Huawei, отмечает, что стремительное внедрение ИИ, в том числе генеративных сервисов, изменило требования к традиционным платформам СХД. Поэтому возникают проблемы с производительностью, надёжностью и масштабируемостью. В этой связи Huawei стремится переосмыслить подход к хранению информации, внедряя инновации по ряду направлений, включая новые парадигмы данных, повышение устойчивости и быстродействия. Платформа OceanStor A800 использует архитектуру SmartMatrix Pro для разделения уровней данных и управления: это позволяет передавать информацию через интерфейсные модули на/с SSD, обходя узкие места, связанные с CPU и памятью. В результате, как утверждается, производительность повышается практически на порядок по сравнению с традиционными хранилищами. В частности, A800 до восьми раз быстрее позволяет загружать наборы данных для обучения ИИ, а средняя утилизация GPU/NPU в кластере повышается почти на треть. Новая система выполнена в формате 8U. Конструкция включает два модуля обработки с поддержкой CPU и GPU, а также два модуля хранения на основе SSD. В качестве CPU применяется фирменное изделие Huawei Kunpeng с архитектурой Arm. Модули обработки могут дооснащаться дополнительными GPU, DPU и NPU. Основной шиной является PCIe 5.0. Показатель IOPS достигает 24 млн, а пропускная способность — 500 Гбайт/с. СХД поддерживает проприетарные накопители Palm SSD с высокоплотной упаковкой NAND-чипов и вместимостью 30 или 50 Тбайт, а в следующем году будет реализована возможность применения SSD на 128 Тбайт. Утверждается, что OceanStor A800 обеспечивает плотность хранения более 1 Пбайт на 1U, а энергоэффективность составляет 0,7 Вт/Тбайт. Платформа может масштабироваться до 512 контроллеров и 4096 вычислительных блоков, что обеспечивает вместимость в экзабайты и возможность обслуживания моделей с триллионами параметров. Применена параллельная файловая система OceanFS, причём Huawei предлагает унифицированное управление данными сразу в нескольких кластерах посредством Omni-Dataverse. Поддерживаются протоколы NFS, SMB, HDFS, S3, POSIX, MP-IO, а также интерфейсы для работы с векторными/тензорными данными. Предусмотрены встроенные средства обнаружения программ-вымогателей, эффективность которых, по заявлениям Huawei, достигает 99,99 %.

01.05.2024 [17:00], Сергей Карасёв

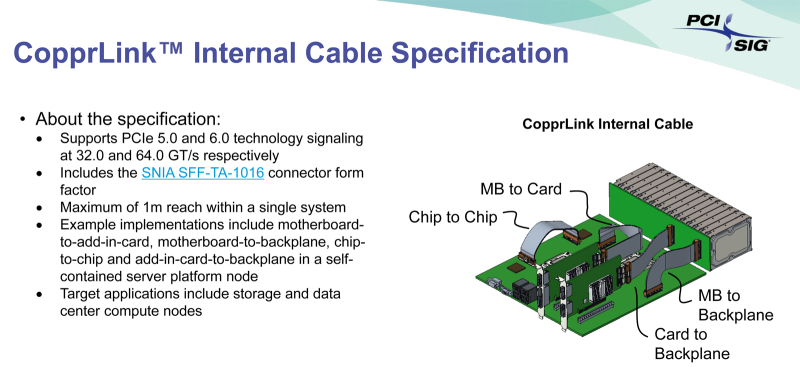

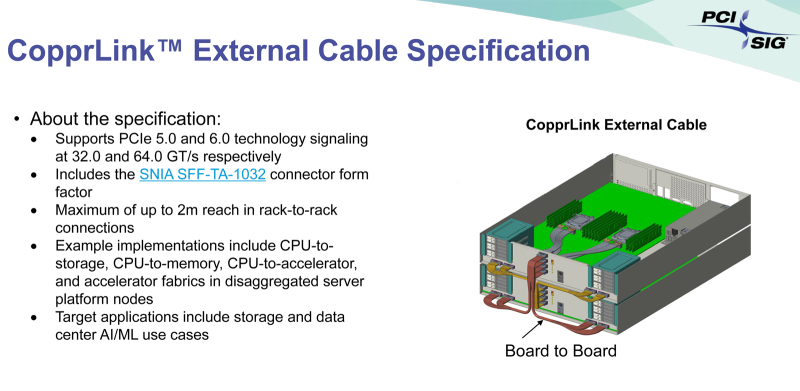

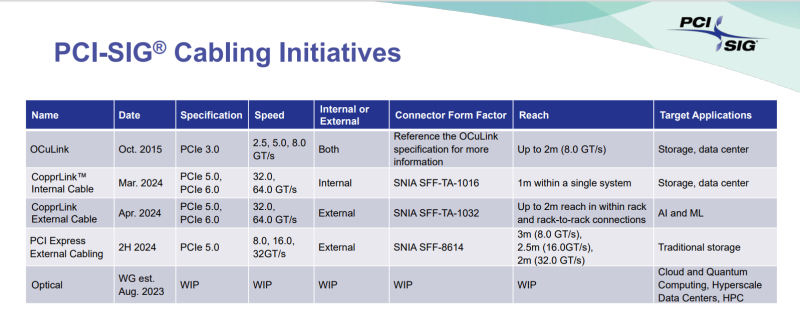

Внутри и снаружи: PCI-SIG обнародовала спецификации кабелей CopprLink для PCIe 5.0/6.0Организация PCI Special Interest Group (PCI-SIG) обнародовала спецификации электрических кабелей и разъёмов CopprLink для внешних и внутренних подключений PCIe 5.0/6.0. Новые соединения на основе меди позволят заменить существующие кабели OCuLink в тех случаях, когда требуется более высокая пропускная способность. Стандарт CopprLink был анонсирован в конце 2023 года. Кабели данного типа обеспечат высокоскоростные подключения в пределах отдельных систем, а также между различными узлами в составе стойки. Кроме того, как отмечалось ранее, разрабатываются варианты для межстоечного соединения. Спецификация CopprLink для внутренних подключений:

Спецификация CopprLink для внешних подключений:

Отмечается, что в дальнейшем кабели CopprLink будут развиваться с учётом возможностей интерфейса PCIe следующих поколений. Технология CopprLink, как ожидается, будет востребована в сферах, где необходимы небольшие задержки, включая дата-центры, производительные СХД, сети и пр. В будущем ожидается появление оптических кабелей PCIe.

08.04.2024 [09:48], Сергей Карасёв

CXL из коробки: Samsung представила стоечный массив памяти CMM-BКомпания Samsung анонсировала решение под названием CXL Memory Module — Box (CMM-B): это массив модулей памяти CXL, предназначенный для монтажа в стойку. Новинка совместима с решениями Supermicro Plug and Play. В состав CMM-B входят восемь пулов CXL-памяти на базе модулей E3.S CMM-D (PCIe 5.0) ёмкостью 2 Тбайт каждый. Таким образом, суммарный объём достигает 16 Тбайт. В составе стойки доступ к этому массиву могут получать три сервера Supermicro. Такая архитектура позволяет выделять необходимый объём памяти в соответствии с текущими нагрузками, устраняя узкие места в вычислительных системах. Через консоль SCMC (Samsung Cognos Management Console) можно отслеживать распределение памяти.

Источник изображений: Samsung Устройство CMM-B выполнено в формате 4U. Заявлена совместимость со стандартами CXL 1.1/2.0. Пропускная способность достигает 60 Гбайт/с, тогда как задержка находится на уровне 596 нс. С точки зрения «чистой» производительности один модуль CMM-B работает медленнее, чем двухканальная подсистема оперативной памяти DDR5-4800. Тем не менее, устройство значительно быстрее, чем даже наиболее передовые SSD.  Представленная стоечная система разработана в тесном сотрудничестве с Supermicro. В состав решения, помимо CMM-B и трёх серверов, входит PCIe-коммутатор. Система предназначена для приложений, которым требуется большой объём памяти, таких как ИИ, анализ массивов информации и in-memory базы данных. CMM-B позволяет динамически выделять необходимую память системе, когда она необходима ей. Благодаря этому повышается гибкость использования инфраструктуры и снижаются энергетические затраты, говорят создатели.

29.03.2024 [13:39], Сергей Карасёв

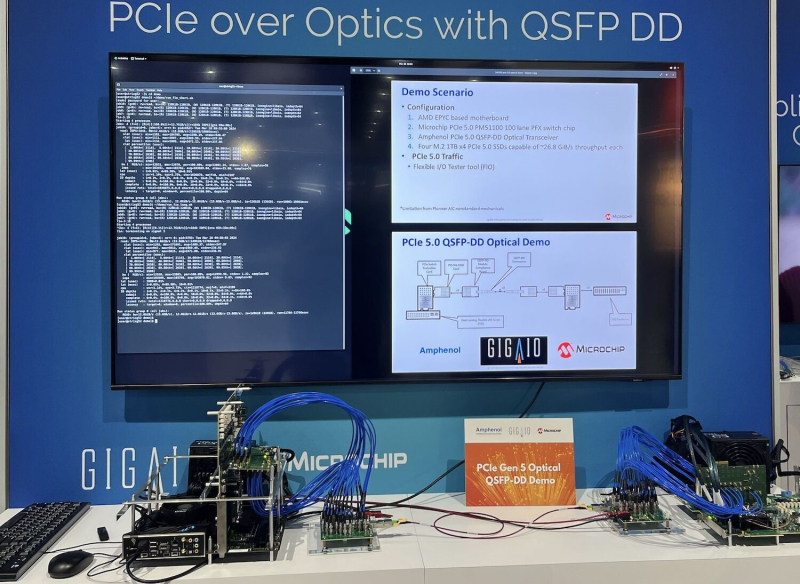

GigaIO представила оптические кабели PCIe 5.0 для развёртывания масштабных ИИ-кластеровКомпания GigaIO, разрабатывающая систему распределённого интерконнекта на базе PCI Express под названием FabreX, представила первые в отрасли оптические кабели QSFP-DD с поддержкой PCIe 5.0. Отмечается, что оптические кабели обеспечивают ряд преимуществ перед традиционными медными соединениями. Это, в частности, повышенная пропускная способность. Кроме того, длина оптических линий может превышать 3 м, что является ограничением для медных кабелей. Представленные кабели используют конфигурацию PCIe 5.0 x8 с возможностью агрегации 16 линий. Благодаря этим изделиям упрощается развёртывание высокопроизводительных систем GigaIO SuperNODE, которые позволяют связать воедино до 32 ускорителей посредством упомянутой платформы FabreX. Отмечается, что оптические кабели способны обеспечить передачу данных с высокой скоростью на десятки метров. Таким образом, несколько систем SuperNODE или SuperDuperNODE могут быть объединены в единый кластер для решения наиболее ресурсоёмких задач ИИ. Медные соединения обычно ограничивают размер кластеров двумя–тремя стойками. В случае оптических кабелей предоставляется гораздо большая гибкость в плане конфигурации оборудования. В результате системы SuperNODE могут быть развёрнуты даже в тех дата-центрах, в которых существуют жёсткие ограничения по мощности и охлаждению в расчёте на стойку. Оптические кабели QSFP-DD с поддержкой PCIe 5.0 станут доступны предстоящим летом.

24.03.2024 [02:19], Сергей Карасёв

WEKApod для SuperPOD: WekaIO представила платформу хранения данных для ИИ-кластеров NVIDIAКомпания WekaIO, разработчик решений для хранения данных, анонсировала высокопроизводительное All-Flash хранилище WEKApod, оптимизированное для работы с платформой NVIDIA DGX SuperPOD на базе NVIDIA DGX H100. Новинка объединяет специализированное ПО WekaIO и «лучшее в своем классе оборудование». Хранилище WEKApod спроектировано для ресурсоёмких нагрузок ИИ. Базовая конфигурация состоит из восьми 1U-узлов, обеспечивающих суммарную вместимость в 1 Пбайт. Показатель IOPS (операций ввода-вывода в секунду) достигает 18,3 млн. Заявленная пропускная способность при чтении составляет до 720 Гбайт/с, при записи — до 186 Гбайт/с. Утверждается, что восемь узлов WEKApod обеспечивает производительность, необходимую для 128 систем NVIDIA DGX H100. При этом WEKApod может масштабироваться до сотен узлов блоками по четыре узла. Таким образом, можно сформировать систему необходимой вместимости с высокой отказоустойчивостью для обучения больших языковых моделей (LLM), ИИ-приложений, работающих в реальном времени, и пр.

Источник изображения: WekaIO Отмечается, что архитектура WEKApod обеспечивает снижение энергопотребления благодаря оптимальному использованию пространства, улучшенному охлаждению и средствам энергосбережения в режиме простоя. В результате, достигается потенциальное сокращение углеродного следа до 260 т/Пбайт. WEKApod использует адаптеры NVIDIA ConnectX-7 и NVIDIA Base Command Manager для мониторинга и управления. Каждый из узлов несёт на борту процессор AMD EPYC 9454P (48C/96T; 2,75–3,80 ГГц; 290 Вт) и 384 Гбайт памяти DDR5-4800. Есть посадочные места для 14 накопителей формата E3.S с интерфейсом PCIe 5.0. Производительность в расчёте на узел достигает 90 Гбайт/с при чтении и 23,3 Гбайт/с при записи, а величина IOPS равна 2,3 млн при произвольном чтении и 535 тыс. при произвольной записи.

14.03.2024 [10:03], Сергей Карасёв

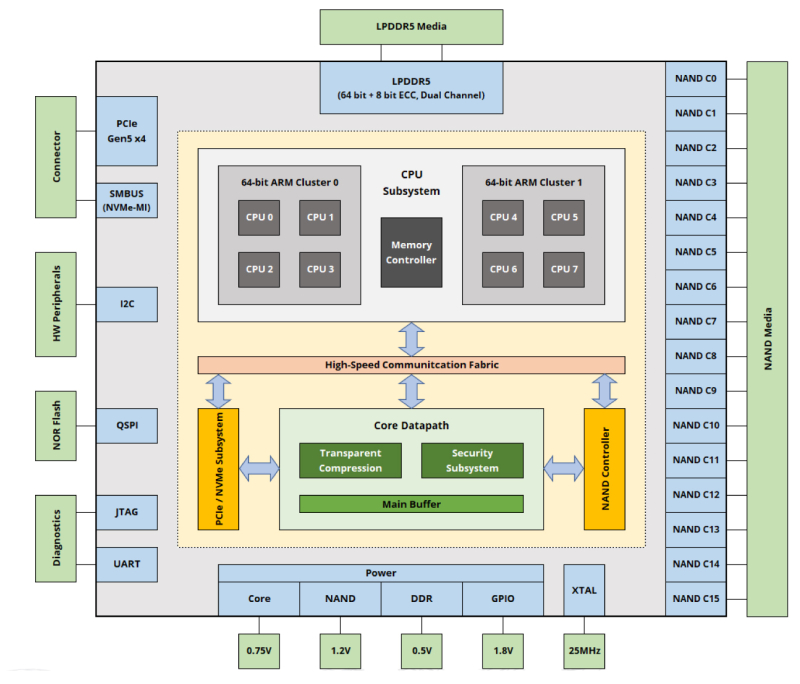

ScaleFlux представила платформу SFX 5016 для вычислительных SSD нового поколенияКомпания ScaleFlux анонсировала контроллер SFX 5016, предназначенный для создания вычислительных SSD следующего поколения. Такие устройства могут частично взять на себя нагрузку по обработке хранимых данных и тем самым высвободить ресурсы CPU для других задач. Представленное изделие соответствует спецификации NVMe 2.0 и стандарту OCP Datacenter SSD Spec 2.0. Поддерживается интерфейс PCIe 5.0. Возможно использование до 128 Гбайт памяти LPDDR5, а максимально поддерживаемая вместимость накопителей достигает 256 Тбайт (со сжатием; физически — 64 Тбайт). Контроллер обеспечивает скорость передачи информации до 14 Гбайт/с блоками по 128 Кбайт при последовательном чтении и до 11 Гбайт/с такими же блоками при последовательной записи. Заявленный показатель IOPS (операций ввода/вывода в секунду) достигает 3 200 000 при произвольном чтении данных блоками по 4 Кбайт и 1 500 000 при установившейся произвольной записи. Для контроллера SFX 5016 заявлена поддержка шифрования по алгоритму AES-256. Чип может применяться в составе накопителей с флеш-памятью NAND различных производителей, включая изделия TLC и QLC. Говорится о поддержке TCG Opal в соответствии со стандартом FIPS 140-3. Энергопотребление в активном режиме заявлено на уровне 6 Вт, в режиме простоя — менее 2 Вт. При производстве применяется 7-нм технология. ScaleFlux предлагает вычислительные накопители серий CSD 2000 и CSD 3000 на контроллерах предыдущего поколения. Так, устройства CSD 3000 используют чип SFX 3016. Контроллер SFX 5016, в свою очередь, ляжет в основу SSD серии CSD 5000.

24.02.2024 [19:16], Сергей Карасёв

Dell представила All-Flash СХД PowerScale F210 и F710 на базе Intel Xeon Sapphire RapidsКомпания Dell анонсировала СХД PowerScale F210 и F710, ориентированные на работу с неструктурированными данными. В основу устройств положены аппаратная платформа Intel и усовершенствованное ПО PowerScale OneFS 9.7. Решения выполнены в форм-факторе 1U на серверной платформе Dell PowerEdge R660. В составе модели PowerScale F210 задействован процессор Xeon Silver 4410Y поколения Sapphire Rapids, насчитывающий 12 ядер (24 потока) с максимальной тактовой частотой 3,9 ГГц (TDP — 150 Вт). Объём оперативной памяти DDR5 составляет 128 Гбайт. Возможна установка четырёх NVMe SSD вместимостью до 15,36 Тбайт каждый. Вариант PowerScale F710, в свою очередь, несёт на борту два процессора Xeon Gold 6442Y Sapphire Rapids с 24 ядрами (48 потоков) с частотой до 4,0 ГГц и TDP в 225 Вт. Объём ОЗУ равен 512 Гбайт. Имеются отсеки для десяти NVMe SSD ёмкостью до 30,72 Тбайт каждый. Обе СХД могут оснащаться двумя внешними сетевыми интерфейсами 100GbE или 25GbE, а также внутренним сетевым интерфейсом 100GbE (×2). У младшей версии общая вместимость достигает 61 Тбайт на узел и 15 Пбайт на кластер (до 252 узлов), у старшей — 307 Тбайт и 77 Пбайт соответственно. Допускается применение накопителей, основанных на флеш-чипах TLC и QLC. Отмечается, что PowerScale F210 подходит для таких задач, как ИИ и аналитика начального уровня. Модификация PowerScale F710 предназначена для генеративного ИИ и других ресурсоёмких приложений.

13.02.2024 [22:21], Алексей Степин

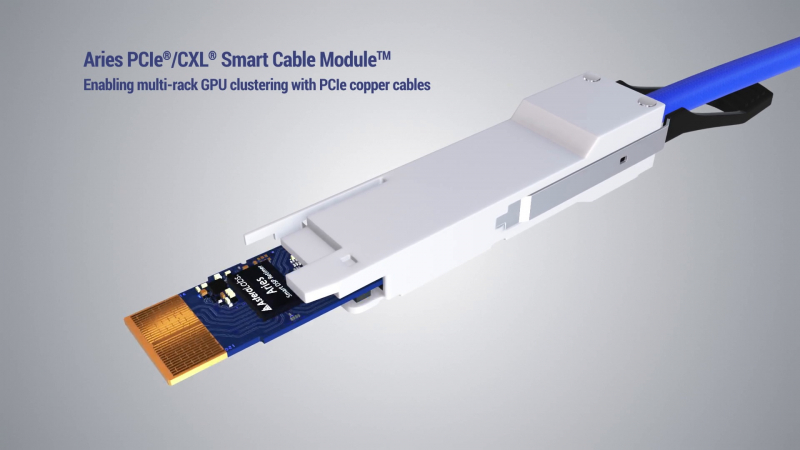

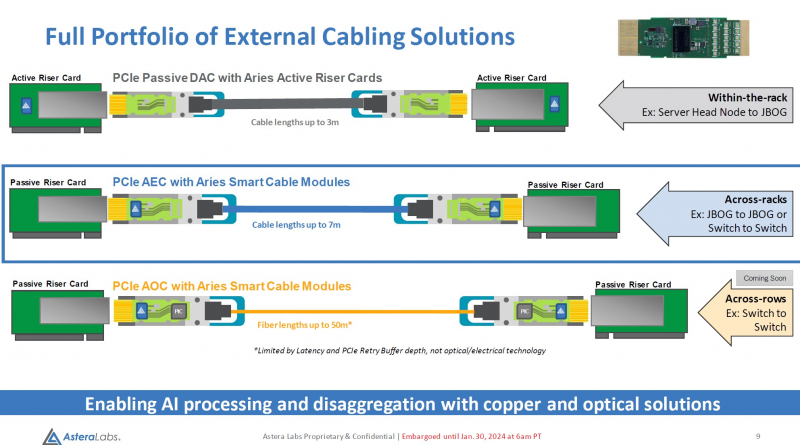

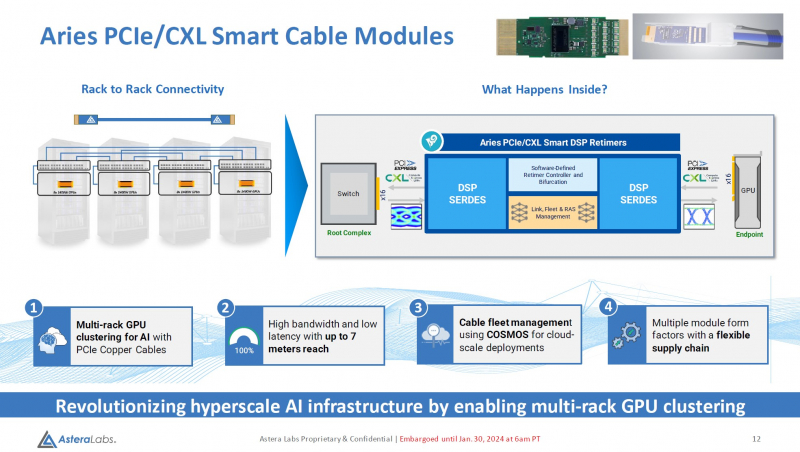

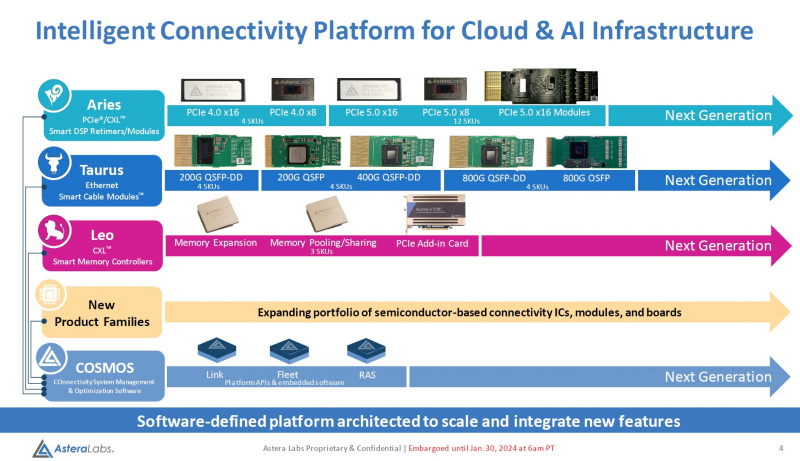

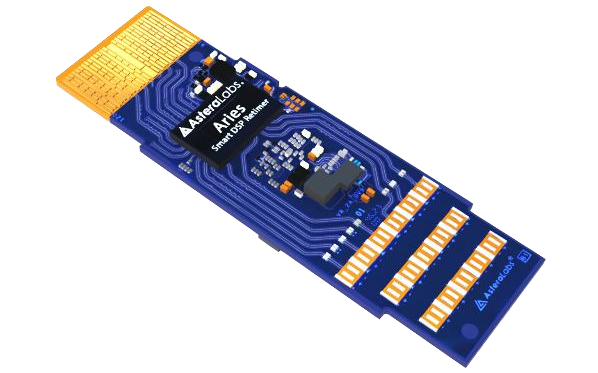

Дотянуться до GPU: Astera Labs представила кабельные модули Aries для PCIe 5.0 и CXLРазвитие пула технологий CXL естественным образом вызывает необходимость в разработке соответствующей кабельной инфраструктуры. Активные оптические кабели достаточно дороги для того, чтобы использовать их на соединениях малой длины, а полностью пассивная «медь» неизбежно потребует установки дополнительных ретаймеров. Astera Labs, разработчик решений для CXL, предлагает решить эту проблему путём использования активных медных кабелей, оснащённых встроенными ретаймерами.

Изображение: Astera Labs Новый тип кабельных модулей получил название Aries PCIe/CXL Smart Cable, он гарантирует устойчивую работу при длине соединения до 7 м, в то время как PCIe 5.0-совместимая пассивная «медь» работоспособна лишь на длинах до 3 м. В основу легли разработанные ещё в 2022 году ретаймеры серии Aries, представленные в рамках анонса целого портфолио решений с поддержкой CXL. Все решения Astera Labs поддерживают единую программно-аппаратную платформу COSMOS, отвечающую за управление и телеметрию, что должно упростить развёртывание и эксплуатацию крупномасштабных систем на базе PCIe/CXL-интерконнекта любой сложности, от комплексов GPU-кластеризации до пулов CXL-памяти. Сами ретаймеры Aries несмотря на свою компактность, представляют собой сложные устройства с достаточно производительными для работы на скоростях PCIe 5.0 сигнальными процессорами (DSP). Помимо DSP в состав чипа входит блок телеметрии и удалённого управления и программно-определяемый контроллер, отвечающий за режимы бифуркации. Применение «умных» медных кабелей Astera упростит и удешевит конструкцию систем с более чем одной стойкой, а также позволит использовать более разнообразные варианты топологии. Для подключений длиной более 7 м компания ведёт разработку активных оптических соединителей. Стоит отметить, что готовые кабели Astera Labs не продаёт. Она поставляет кабельные модули, которые гиперскейлеры и ОЕМ-производители вольны использовать в своих решениях так, как им представляется необходимым.

11.01.2024 [21:04], Сергей Карасёв

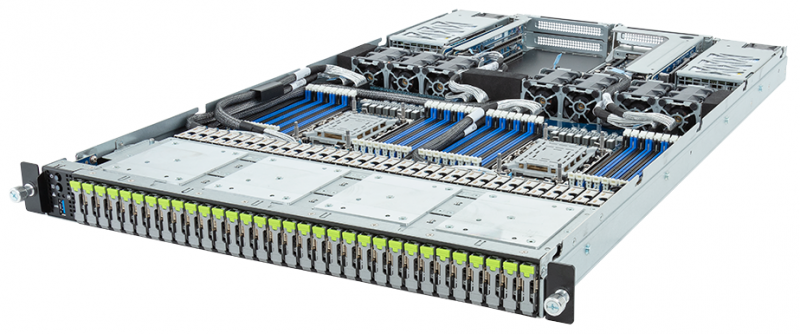

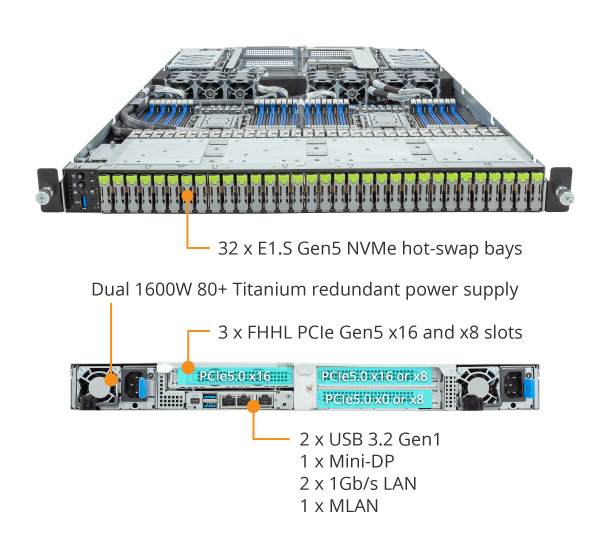

Gigabyte представила сервер хранения S183-SH0 для больших языковых моделейКомпания Gigabyte анонсировала сервер хранения S183-SH0, предназначенный, как она сама говорит, для работы с большими языковыми моделями (LLM). Новинка, выполненная в форм-факторе 1U, допускает установку двух процессоров Intel Xeon Sapphire Rapids или Emerald Rapids.

Источник изображений: Gigabyte Во фронтальной части сервера расположены 32 посадочных места для накопителей E1.S NVMe SSD с возможностью горячей замены. Это позволяет сформировать сверхбыстрое хранилище для обработки данных LLM. Кроме того, предусмотрены два коннектора для накопителей M.2 с интерфейсом PCIe 3.0 x4 или SATA 3.0. Доступны 32 слота для модулей оперативной памяти DDR5-4800/5600. Могут быть установлены три карты FHHL с интерфейсом PCIe 5.0 x16 или x8. В оснащение входит контроллер Aspeed AST2600. Есть два сетевых порта 1GbE (Intel I350-AM2) с поддержкой NCSI и выделенный сетевой порт управления. Питание обеспечивают два блока мощностью 1600 Вт с сертификатом 80 PLUS Titanium. Габариты сервера составляют 438 × 43,5 × 730 мм. Имеются три порта USB 3.2 Gen1 (один выведен на лицевую панель), интерфейс Mini-DP и гнёзда RJ-45 для сетевых кабелей. Реализована система воздушного охлаждения с семью вентиляторами диаметром 40 мм. Диапазон рабочих температур — от +10 до +35 °C. |

|